機器人專題(二)/機器人出事後,是程式沒寫好、規範不周全,還是廠商的問題?

文/劉珈均

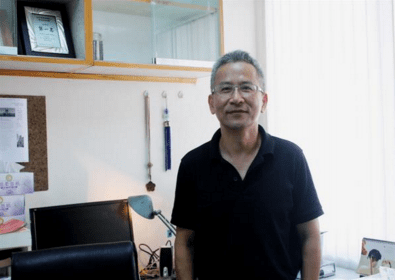

機器人逐漸走進人類生活,兩者之間的互動也開始增加,本次專題訪問了交通大學電機工程系教授楊谷洋,探討機器人與人類社會的正要萌芽的關係。

賣座電影《星際效應》中有個相當搶眼的配角 ── 機器人塔斯(Tars),它負責操控太空船、協助太空人執行任務,而為了與人類融洽相處,塔斯有「不八卦設定」、「坦白參數」等設計。真實生活中,也有學者投入「機器人倫理」研究,探討機器人可能面臨的兩難環境與責任歸屬、將人類生活中應對進退的判斷與行為化為程式輸入機器人。

機器人倫理學大致興起於十年前,機器人專家(Gianmarco Veruggio)在 2002 年創造了機器倫理學(roboethics)這名詞,探討機器人設計、建造與使用,機器人在人類生活場域該有的「應對進退」。

如果機器人當警察?

「機器人是機器,沒有意識,不會自己想要去做什麼,哪來倫理問題?」楊谷洋解釋,像幾台 Roomba 在一起不會有學長學姊觀念,倫理議題基本上來自設計者與其所在的社會所持的倫理觀念。倫理議題出現在「人」,因為我們賦予機器人自主性跟移動能力,與人類互動變高,這使機器人與冰箱、吸塵器有所區別。

「會有倫理議題是因為我們讓機器人面對一些需要考慮倫理的問題,」他舉例:「如果要機器人當警察,就會遇到執法問題。」若機器人遇到歹徒,該如何處理?這就必須為機器人設立一些規則(寫程式),首先,機器人必須區別對方是否為歹徒,例如靠影像處理識別對方手上有拿槍,也不能對方有槍就出手,還要考量槍是否對著我?槍對著我的角度為何,差個 0.1 度呢?出事後該找誰究責,是規則沒定好還是程式沒寫好,還是機構出問題?

歸結起來,機器人倫理大概分三個層次討論:

人類要機器人面對的情境有哪些倫理問題;如何訂定規則,讓程式精確的實踐倫理觀念;意外事件發生後的責任歸屬。

「光這三個問題就很忙了!」

現實生活中已有機器人涉入糾紛。美國直覺手術公司(Intuitive Surgical Inc)於 1999 年發表的「達文西手術機器人系統」(da Vinci robotic surgery system)是目前全球應用最廣泛的手術機器人,台灣也在 2004 引進。其外型為機械手臂,由醫師操縱,幫助進行微創手術,優點有傷口小、減少出血、恢復容易。

不過,凡機械產品就可能出現瑕疵或故障,曾發生機械爪緊抓著病患的身體組織不放,還重擊躺在手術台上的患者。楊谷洋估計,在歐美地區,達文西機器人涉入的醫療官司大概已超過百件。這些訴訟判例很可能會是探討機器人「責任」歸屬的開端。

機器人會接管人類社會嗎

機器人與社會的互動關係漸受矚目,定出「robot」一詞的捷克舞台劇就有機器人造反情節,也有科學家擔心人工智慧終有一天會反過來傷害人類,如英國物理學家霍金(Stephen Hawking)去年受 BBC 訪問時表示對其顧慮,當哪天人工智慧超越人類,人類受限於緩慢的生物演化,可能無法與之匹敵;特斯拉電動車公司(Tesla)執行長伊隆馬斯克(Elon Musk)也曾表示人工智慧是潛在威脅,可能比核能武器更可怕。

羅德尼・布魯克斯(Rodney A. Brooks)曾任 MIT 人工智慧實驗室主任,也是機器人公司 iRobot 創辦人之一,他在《我們都是機器人》書中提到,「機器人接管世界」的惡夢要成真,機器人必須滿足幾項假設條件如:

- 機器人不需人類協助就能自行修復和繁殖。

- 有可能製成不帶人類情感的智慧型機器,且特別是對人類沒有同理心。

- 機器有生存慾望,而且會想控制環境以維持自身生存。

- 當機器人作出決定時,我們控制不住他們。

楊谷洋說,這得看機器人有多聰明,他還沒看到那個點,再怎麼說機器人就是「具有靈活機構的電腦」,大家毋須擔心太多。若像《2001 太空漫遊》電影情節,太空船為了利於任務進行而殺害人類組員,機器人是根據程式作判斷、執行任務,則又回到原則設定的範疇。「在工程界有些明規則,任何工業產品不能傷害到人類,機器要安全、機器人是要被人控制。」楊谷洋說。

比起機器人造反的隱憂,更逼近現實生活的或許是研發上戰場的機器人。機器人是否應該出現在戰場上?是否該限制各國開發殺戮機器人(killer robot)?2014 年 5 月,聯合國特定武器會議(Convention on Certain Weapons,CCW)就對此展開辯論,正方認為這可代替士兵,減少傷亡,也不會基於恐懼或復仇心理而殺害平民;反方則提出,機器人無法依比例原則執行任務,無法精確分辨敵人,可能造成更多無辜傷亡。

2015 年七月底,霍金、馬斯克、蘋果電腦共同創辦人沃茲尼亞克(Stephen Gary Wozniak)等超過一千位人工智慧(AI)和機器人領域相關研究者,於阿根廷舉辦的人工智能國際聯合會議聯名發布公開信,敦促聯合國禁止各國研發「進攻性自主武器」。

科技是雙面刃,有人覺得科技本身是中性的,端看人如何使用,但如果是像原子彈或殺戮機器人這種很明顯容易用來傷害人類的發明,科學家是否有責任引導規範該科技的使用,抑或「中立的」負責研發就好了?

「常常有學生問我,我們一天到晚做這種感覺很可怕的機器人要幹嘛?我想這是人類一種無可自拔的誘惑吧。」

楊谷洋說,科學家總會想作更先進的技術,並沒有想要危害社會,任何科技產品都有風險,它可以幫你很多,這些權衡不單純是機器人學界的議題。被譽為台灣機器人之父的羅仁權則認為,科學家都會想探究知識或技術的極致,但科學家要有所意識自己的發明可能有何後果。若機器學習能力越來越強,當它有創造或衍生能力的時候,若沒完善規範,就可能作出超乎我們預期的事。目前還沒有明文規定機器人發展限制,或許日後會有機器人條約推動。

封面圖面來源:photo via C_osett @flickr, CC License

留言討論